ChatGPT 진지하게 좆같은 이유

작성자 정보

- 바람의미로 작성

- 작성일

컨텐츠 정보

- 495 조회

- 목록

본문

일단 0,1, 6,8,9 이 숫자들은 수수께기 매니아들에게 식상함.

거꾸로 뒤집으면 숫자가 되는 숫자들로 하도 많이 써먹으니까.

그런데 chatGPT는 과연 문제를 풀수있을지 궁금했음.

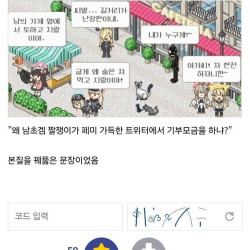

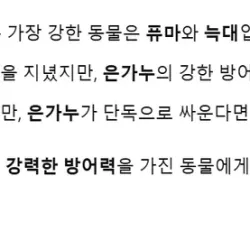

밑은 대화내용 일부 캡쳐한건데, 길어서 다 읽지 않아도 됨.

요약하자면,

ChatGPT와 대화할때,

사용자가 정답을 모르는 상태로 대화하면, Chatgpt는 틀린답을 우기기 시작한다는거임.

그리고 틀린 논리를 계속 맞다고 우김.

난 가능한 정답을 말하라는 쪽으로 계속 유도했지만,

GPT는 계속 자기 답이 맞다는 식으로 1시간 넘게 우김.

진짜 존나 답답했음.

(참고로 유로 최신버전사용했음)

이걸로 코딩한다?

불가능함.

사용자가 정답을 알고있고 모든 코드를 다 검수해야함.

[ 읽기 : 0 / 쓰기 : 0 / 댓글 : 10 / 공유 : 50 ]

관련자료

-

이전

-

다음

댓글 0

등록된 댓글이 없습니다.